Что такое robots.txt?

20.10.2022

Результаты поисковой выдачи содержат релевантные ресурсы в ответ на пользовательский запрос. Перед тем как дать информацию, поисковые роботы сканируют сайт и отправляют в индекс. Как управлять Google ботами? В статье разбираем, что такое robots.txt, из чего он состоит и какие инструменты для составления файла существуют? Зачем нужен файл robots.txt?

Содержание:

- Как поисковые боты сканируют страницы?

- Что такое robots.txt?

- Структура файла robots.txt

- ТОП-6 ошибок в robots.txt

- Пример robots.txt

- Создание и валидация robots.txt

- Сервисы и инструменты для проверки robots.txt

- Что исключать из индекса с помощью robots.txt?

- Выводы

Поисковые роботы — это системные алгоритмы, которые проверяют доступные страницы в интернете. Google индексирует информацию, которую вы публикуете. Можно ли управлять ботами? Есть возможность направить системных ботов. Для этого необходимо создать файл robots.txt и показать, какие страницы стоит индексировать, а какие нет.

Как поисковые боты сканируют страницы?

Работа поисковых ботов заключается в поиске нового контента, которые они добавляют в поисковый индекс. Их также называют алгоритмами, краулерами. Боты переходят по ссылкам на страницах в интернете и сканируют содержащую информацию. Когда пользователь вводит запрос в строку, релевантные результаты извлекаются из индекса и ранжируются согласно рейтингу.

Задача поисковых роботов — предоставить пользователям лучшие варианты ответов на их запросы. Почему это важно? Понимание того, как боты находят, индексируют и ранжируют контент, поможет повлиять на позиции сайта в органических результатах поисковой выдачи. Более высокие позиции привлекают больше трафика, кликов и конверсий соответственно.

Как поисковики сканируют страницу? Рассмотрим самую популярную поисковую систему в мире Google, доля рынка которой составляет 92%.

Google содержит индекс, где находится больше триллиона веб-страниц. Поэтому система всегда сможет найти любую ссылку, ресурс и т.д. Алгоритмы начинают индексировать с URL-адреса. Далее Googlebot сканирует и обрабатывает страницы согласно прописанному алгоритму и после этого отправляет в цифровую библиотеку под названием поисковый индекс.

Существует понятие, как краулинговый бюджет. Это ограниченное количество страниц, которое боты могут проиндексировать за один раз, и определяется в индивидуальном порядке. Поэтому важно исключать ненужные данные и указывать, что именно необходимо отправить в индекс. Robots.txt это файл, с помощью которого это можно реализовать.

Что такое robots.txt?

Отвечая на вопрос, что такое robots.txt это инструкция, хранящийся в формате текста на сервере. Текст robots.txt это команды, созданные из латинских символов. С помощью этой информации поисковые роботы понимают, какие страницы можно индексировать. Если не прописывать robots.txt, система будет индексировать все страницы, включая дубли или другой «мусор». Каждая строка robots.txt несет одну команду в форме директивы.

Robots.txt можно редактировать по необходимости, чтобы закрыть отдельные страницы от индексации. Чаще это лендинги под временные акции и распродажи, версии для печати, системные файлы и каталоги, пустые страницы.

Важно! 500 кб — максимальный размер файла robots.txt, установленный Google.

При обработке robots.txt, роботы получают 3 правила для индексирования:

- Полный доступ дает разрешение для сканирования всего сайта.

- Частичный доступ позволяет сканировать отдельные элементы.

- При полном запрете Googlebot не сможет ничего просканировать.

Структура файла robots.txt

Robots.txt это текстовый файл, который прописывается в блокноте, любом текстовом редакторе (Notepad++, Sublime). Его добавляют в корневую часть сайта. Такие кодовые инструкции для роботов задаются с помощью директив с различными параметрами.

Структура robots.txt это:

- user-agent — название робота, который должен просканировать данную страницу

- allow/disallow — директивы (команды) для выполнения роботами

Что такое robots.txt и из чего он состоит? Разберем директивы robots.tx по отдельности.

User-agent

Указывает робота, для которого будут актуальны описанные правила robots.txt. К популярным относятся:

- Googlebot — основной бот Google.

- Googlebot-Image — бот картинок.

- Googlebot-Mobile — индексатор мобильной версии.

- Googlebot-Video — робот для сканирования видео.

Готовый текстовый документ robots.txt следует загрузить в корневую папку с названием сайта, где находится файл index.html и файлы движка.

Поисковая система каждый раз при сканировании будет обращаться к robots.txt. Это дает ей информацию и понимание, что можно индексировать, что нет.

Директива allow/disallow

Команда robots.txt разрешает или запрещает сканирование. Для каждого отдельного раздела, папки или URL нужно прописывать правила с помощью знака «/». Например:

- Для запрета папки сайта указываем такую последовательность в robots.txt это:

Disallow: /folder/ - Для запрета только одного файла (в данном случае изображения):

Disallow: /folder/img.jpg

Директива sitemap

Директива Sitemap в robots.txt это направление ботам, где найти карту сайта в формате XML, что поможет им быстрее ориентироваться в структуре ресурса.

Директива Clean-param

Правило robots.txt это запрет для индексации информации, которая содержит динамические параметры. Это страницы с одинаковым контентом — дубли, приводящие к понижению позиции сайта в выдаче.

Директива Crawl-delay

Команда robots.txt подходит для крупных сайтов с большим количеством страниц, что может влиять на скорость загрузки. Каждый раз когда роботы заходят на сайт, это также дает дополнительную нагрузку.

Чтобы снизить давление на сервер, следует использовать в robots.txt директиву Crawl-delay, которая ограничивает количество сканирований. Время в секундах — это параметр, который указывает роботам, сколько раз за определенный период следует сканировать сайт.

ТОП-6 ошибок в robots.txt

Ошибки в robots.txt это нарушения, которые приводят к последствиям. Как отмечает Google, у поисковых роботов гибкие алгоритмы, поэтому небольшие недочеты в robots.txt не сказываются на их работе. Однако если в robots.txt есть ошибки, лучше их исправить. Какие распространенные ошибки существуют в robots.txt?

- Неправильное расположение robots.txt. Где находится robots.txt? Напомним, что robots.txt это файл, который должен быть расположен в корневой папке. В обратном случае роботы не смогут его найти.

- Ошибка названия. Всегда название следует писать с маленькой буквы — robots.txt.

- Перечисление папок через запятую. Каждое новое правило пишется с новой строки. При перечислении правил через запятую директива robots.txt не сработает.

- Отсутствие ссылки на файл sitemap.xml. С помощью него роботы получают информацию о структуре сайта и его главных разделах, которые Google сканируют в первую очередь. Данный пункт robots.txt особенно важен для SEO-продвижения сайта.

- Пустые команды в robots.txt это папки и файлы для индексирования или закрытия от индексации, которые нужно не забывать прописывать. Многие специалисты оставляют открытые (пустые) allow/disallow.

- Отсутствие проверок robots.txt. Если вы закрываете отдельные страницы, следует периодически проверять установленные правила. Для этого используйте валидатор.

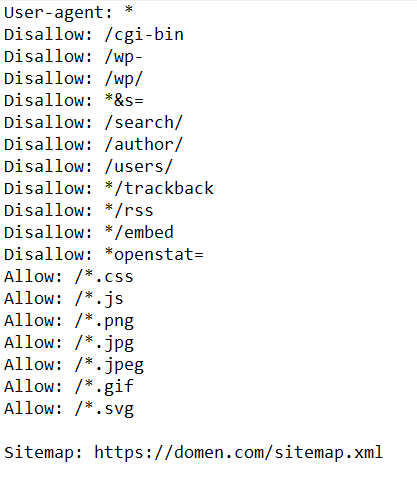

Пример robots.txt

Приводим пример что такое robots.txt:

Создание и валидация robots.txt

Как сделать robots.txt? Потребуется обычный текстовый редактор, встроенный блокнот на компьютере или любой другой сервис. Robots.txt пишется вручную.

Чтобы знать, как правильно составить robots.txt, воспользуйтесь онлайн-генераторами. Это сервисы, с помощью которых можно автоматически быстро сгенерировать robots.txt. Такой способ подойдет для тех, кто имеет несколько сайтов. После автоматической генерации, robots.txt необходимо проверить вручную правильность его написания, чтобы избежать ошибок.

Еще один вариант как создать robots.txt это использовать готовые шаблоны. В интернете есть большое количество файлов для популярных CMS, например WordPress. Шаблон включает стандартные директивы, что упрощает процесс написания, нет необходимости создавать robots.txt с нуля.

Учитывайте, что для написания robots.txt важно владеть базовыми знаниями синтаксиса.

Как мы указывали выше в статье, проверить robots.txt можно несколькими способами. Обнаружить ошибки поможет Google Search Console, который показывает, какие страницы не прошли индексацию.

Сервисы и инструменты проверки robots.txt

Важно проверять правильность написания robots.txt, чтобы сайт корректно сканировался роботами и попадал в поисковый индекс. Для этого советуем использовать дополнительные сервисы:

Google Search Console — главный инструмент для проверки robots.txt, если говорить о системе Google. Сервис включает отдельный раздел как настроить robots.txt. Если ваш сайт еще не подключен, тогда следует зарегистрироваться и добавить его. Google Search Console выводит на экран результат проверки robots.txt, где указано количество ошибок и предостережений.

Seositecheckup — сторонний инструмент для проверки robots.txt на ошибки.

Также можно проверить доступность robots.txt через браузер. Для этого к домену необходимо дописать /robots.txt. Следует провести проверку в нескольких браузерах.

Что исключать из индекса с помощью robots.txt?

Robots.txt это возможность управлять поисковыми алгоритмами и направить их на главные страницы сайта, которые будут видеть пользователи. Правильный robots.txt не должен содержать следующие пункты:

- Дубли страниц. Каждая из них имеет индивидуальный URL с уникальным контентом;

- Страницы с неуникальным контентом;

- Данные с показателями сессий;

- Файлы, связанные с системой CMS и управлением сайтом (шаблоны, темы, панель администратора).

Исключать с помощью robots.txt это значит закрыть все, что не приносит пользу, а также то, что еще находится на стадии доработки или разработки, дублируется, нерелевантные страницы.

Выводы

Googlebot периодически сканирует и индексирует сайт, чтобы определить его позицию в поисковой выдаче. Алгоритмы знают, что такое robots.txt и считывают правила, указанные в файле. Текстовый документ robots.txt включает директивы или команды, с помощью которых роботы определяют какие страницы доступны для индексации.

Существует несколько вариантов, как создать robots.txt для сайта. Важно также понимать, где находится robots.txt и как его настроить. Не забываем делать проверки на ошибки через сервисы.