Как проверить файл robots.txt? ТОП-6 бесплатных инструментов

Файл robots.txt — это набор инструкций для ботов-сканеров поисковых систем. Набор правил помогает управлять ботами, указывая, какие страницы нужно сканировать, а какие — нет.

Перед сканированием веб-сайта, боты-сканеры считывают инструкции в файле и следуют тому, что там написано. Ошибки файла мешают корректному отображению сайта в поисковой сети. Для веб-ресурсов, которые постоянно наполняются контентом, рекомендуют ежедневно проверять robots.txt.

Почему проверка файла robots.txt важна?

Для индексации сайта поисковик «выделяет» краулинговый бюджет — лимит страниц, который бот может проверить на конкретном вебсайте. При отсутствии файла или его некорректном заполнении краулеры могут «потратить» свой бюджет на второстепенные страницы. В этом случае важная информация останется не проиндексированной. Это может привести к неправильной оценке содержимого сайта ботами и понижению позиции веб-сайта в рейтинге поисковой выдачи.

Чтобы выявить ошибки и иметь возможность их вовремя обнаружить, рекомендуется:

- Проверять robots.txt перед запуском сайта.

- Регулярно проводить проверку, особенно после внесения новых данных на сайт, внедрения изменений.

- Использовать несколько сервисов, особенно если продвигаете вебсайт в различных поисковых сетях, а не только в Google.

Инструменты для проверки файла robots.txt

Проанализировать robots.txt можно через панель для разработчиков Google Search Console, онлайн-сервисы и специальные программы для SEO-специалистов.

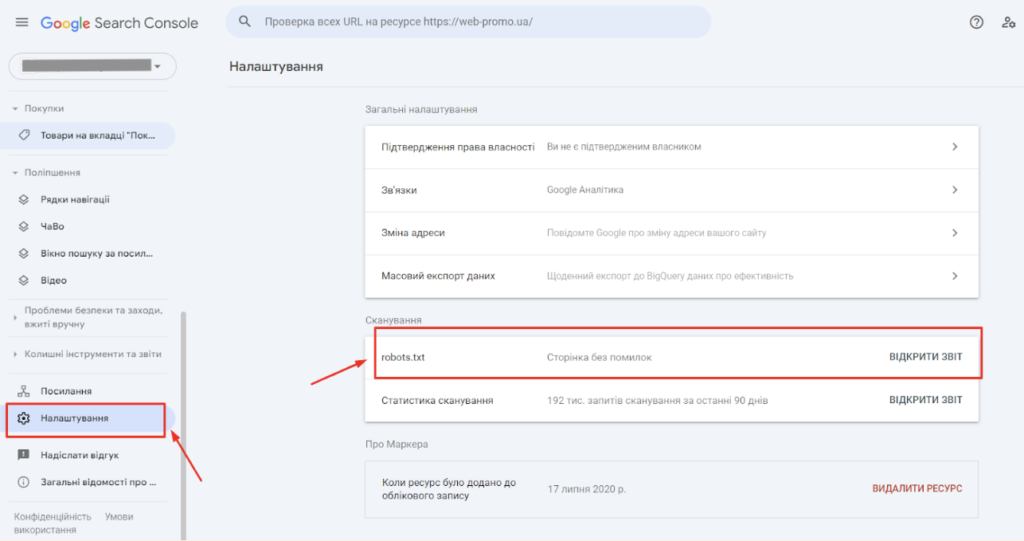

Google Search Console

Это бесплатный инструмент от Google, который состоит из набора информационных панелей и отчетов. Они помогают выяснить, как именно сайт отображается в поисковой сети Google.

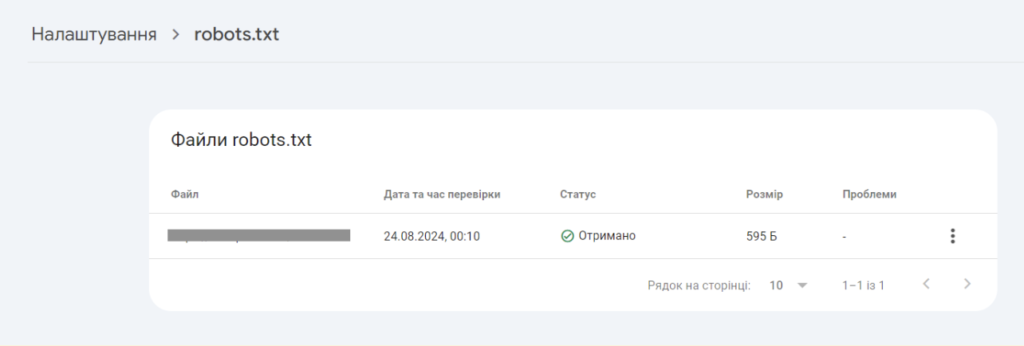

Чтобы проверить robots.txt в Search Console:

- Перейдите в «Настройки».

2. Просмотрите отчет.

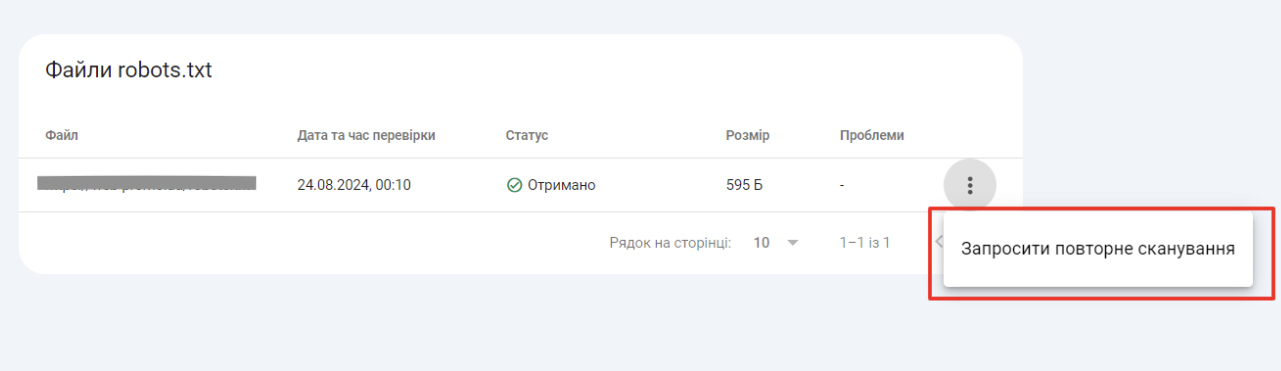

3. После исправления критических ошибок, можно запросить у гугла повторное сканирование файла.

Отчет о robots.txt показывает:

- Получил ли Googlebot доступ к файлу;

- Дату и время проверки;

- Размер файла;

- Таблицу с перечнем проблем.

Важно! Правки нужно вносить не в отчете, а в самом файле на сервере веб-сайта или через административную панель CMS (например, если сайт создан на WordPress или Opencart).

Website Planet

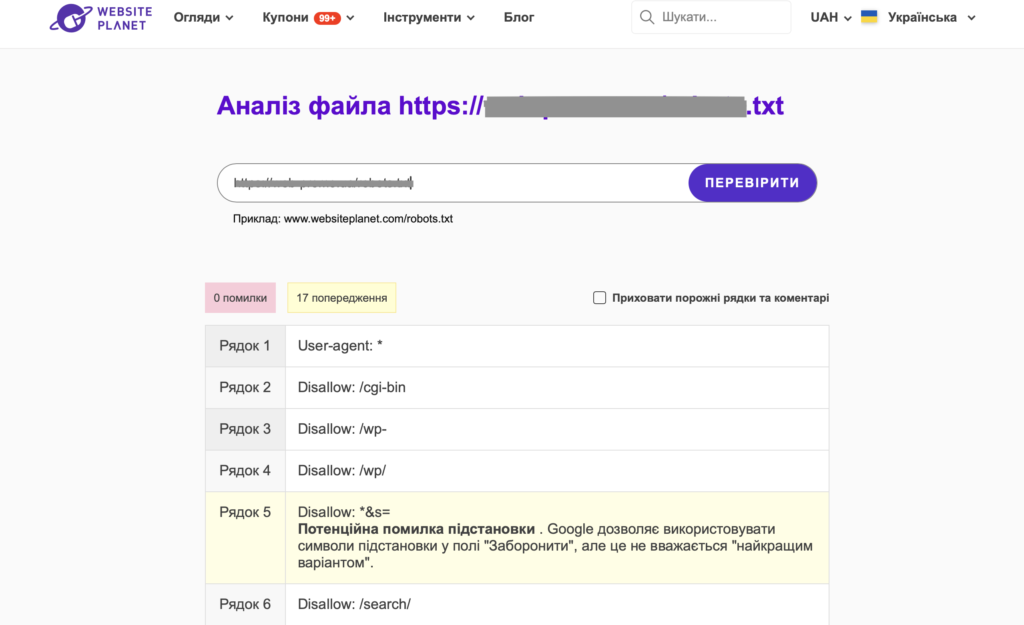

Платформа для маркетологов и SEO-специалистов с различными сервисами — генератор QR-кодов, сжатие изображений, определение возраста домена, проверка файла robots.txt.

Чтобы воспользоваться инструментом, вставьте URL-адрес файла robots.txt в специальную строку на сайте сервиса и нажмите «проверить».

Результатом будет список строк кода robots.txt с предупреждениями и ошибками.

Technicalseo

На сервисе собраны валидаторы для проверки технических характеристик вебсайта. Здесь можно узнать корректность заполнения файлов .htaccess, robots.txt, Sitemap, а также посмотреть, как загружается сайт на мобильных устройствах, сгенерировать микроразметку и т.д.

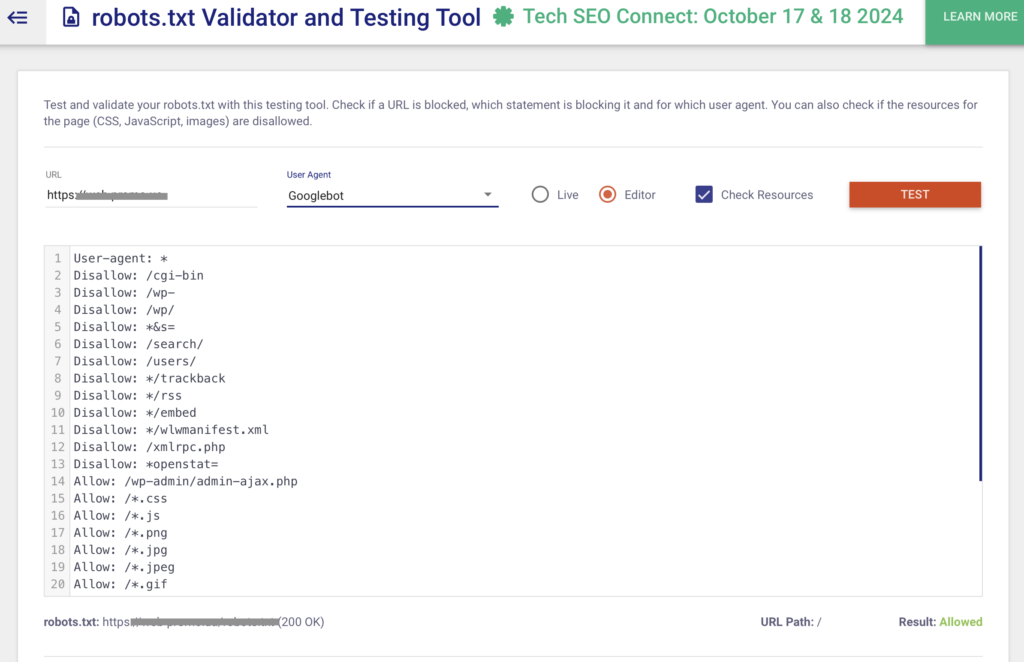

Чтобы проверить robots.txt:

- Вставьте URL-адрес в поисковую строку сервиса.

- Выберите User Agent — Googlebot, Bingbot, DuckDuckGo, Baidu и другие.

- Нажмите «Test» и дождитесь результатов.

Важно! Файл robots.txt, в котором нет ошибок, показывает ответ 200.

Screaming Frog SEO Spider

Это программа, которая сканирует веб-сайты на выявление распространенных SEO-проблем. После загрузки в режиме реального времени можно:

- Найти ссылки, которые не работают;

- Проанализировать метаданные;

- Проверить цепочки редиректов;

- Создать XML- и Sitemaps;

- Проанализировать robots.txt.

Screaming Frog — одна из немногих программ, которая поможет узнать количество страниц на сайте онлайн. Отчет отображает даже веб-страницы, которые заблокированы до сканирования в файле robots.txt.

Первые 500 URL-адресов можно просканировать бесплатно. После исчерпания лимита необходимо покупать лицензию за 259 долларов в год.

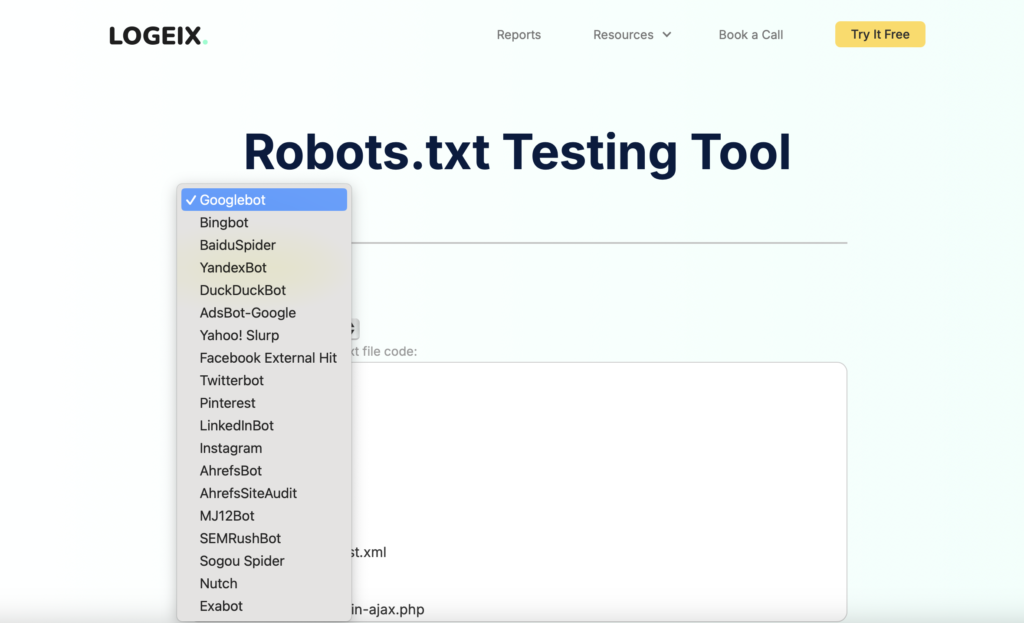

Logeix

Платформа с онлайн-сервисами и плагинами для анализа SEO-показателей веб-сайта. Чтобы проверить файл, введите URL-адрес и выберите бот из списка.

Если robots.txt доступен для сканирования, отобразится зеленая надпись «Crawlable», если нет — красная отметка «Blocked».

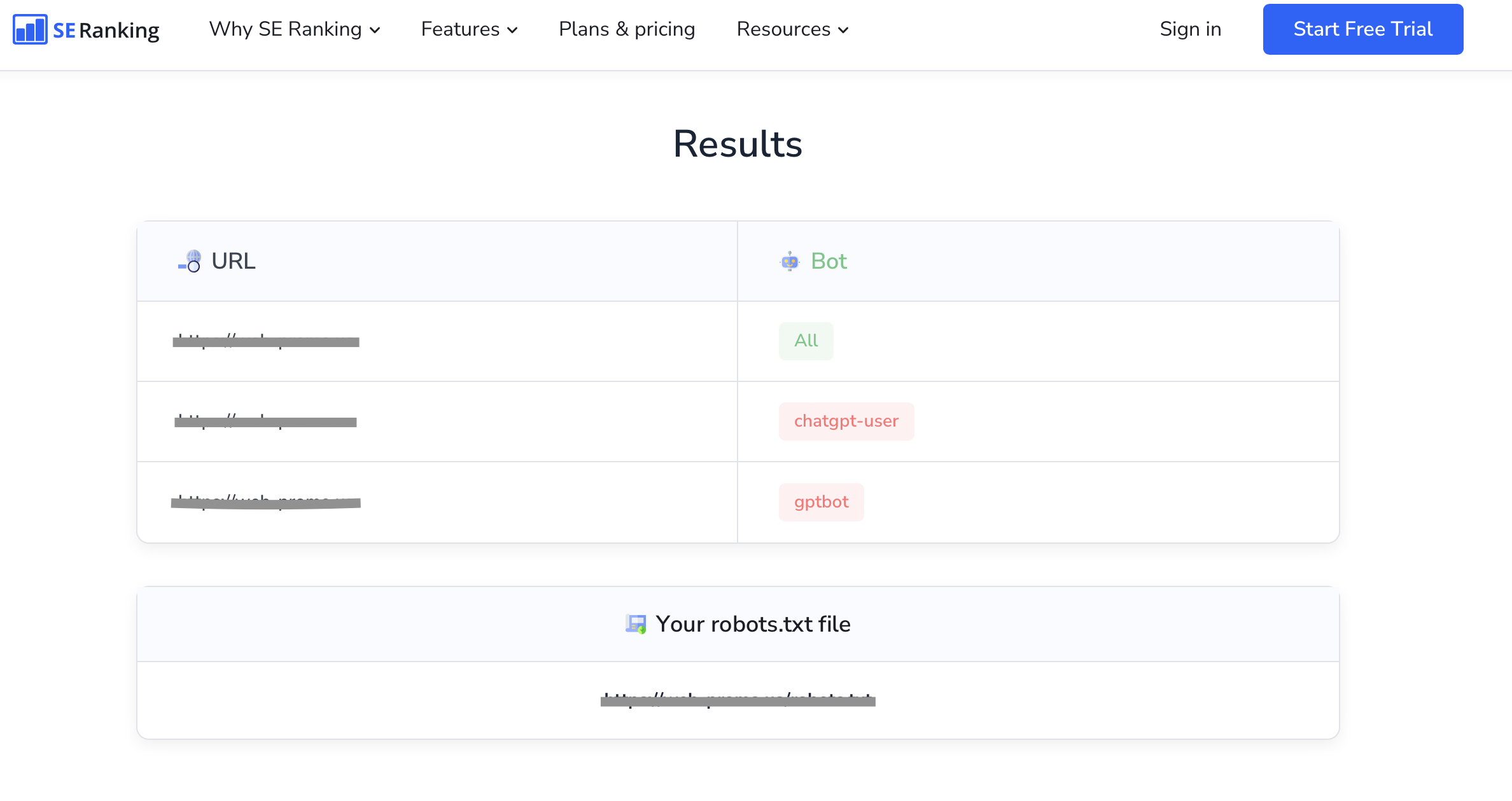

SE Ranking

Многофункциональная платформа для анализа SEO-параметров сайта. Некоторые инструменты, среди которых сервис для проверки robots.txt, доступны полностью бесплатно.

Чтобы проверить robots.txt, вставьте до 100 URL-адресов в специальную строку. В результате вы узнаете статус каждой веб-страницы: открытые для сканирования — будут выделены зеленым, а закрытые — красным.

Выводы

Файл robots.txt — эффективный способ увеличить краулинговый бюджет. То есть помочь программам-сканерам индексировать только важные страницы. Отсутствие файла или его ошибки могут привести к понижению позиции сайта в SERP.

Вовремя выявить неправильные элементы кода поможет регулярная проверка robots.txt. Анализ также рекомендуют делать после каждого обновления веб-сайта.